【sklearn】相互情報量計算をマスター!特徴選択への応用

機械学習における特徴選択は、問題の性質や目的によって異なる特徴量を選択し、モデル性能の向上を目指す重要なステップです。特に 高次元のデータに対しては、相互情報量の計算を用いて関連の強い特徴量を選択することが有効です。scikit-learnには、相互情報量の計算をサポートする機能が揃っており、本章ではその計算方法や特徴選択への応用について詳しく解説します。

【sklearn】相互情報量計算をマスター!特徴選択への応用

相互情報量計算は、機械学習における重要な概念の一つです。scikit-learn(sklearn)を使用することで、相互情報量計算を簡単に実装できるようになります。この記事では、相互情報量計算の基本概念から、特徴選択への応用までをexplainedします。

相互情報量計算の基本概念

相互情報量計算とは、2つのランダム変数之间の相関関係を測定する指標です。相互情報量は、情報理論に基づいて計算され、2つの変数之间の相関関係を観察するために使用されます。scikit-learnでは、`mutual info score`関数を使用することで、相互情報量を簡単に計算できます。

| 相互情報量の種類 | 説明 |

|---|---|

| 相互情報量 | 2つの変数之间の相関関係を測定する指標 |

| 交互情報量 | 2つの変数之间の相関関係を測定する指標 |

| KLダイバージェンス | 2つの確率分布之间の相関関係を測定する指標 |

sklearnにおける相互情報量計算

scikit-learnでは、`mutual info score`関数を使用することで、相互情報量を計算できます。この関数には、2つの配列を入力として受け取り、相互情報量を計算します。mutual info score関数は、以下の式に基づいて計算します。 I(X;Y) = H(X) + H(Y) – H(X,Y)

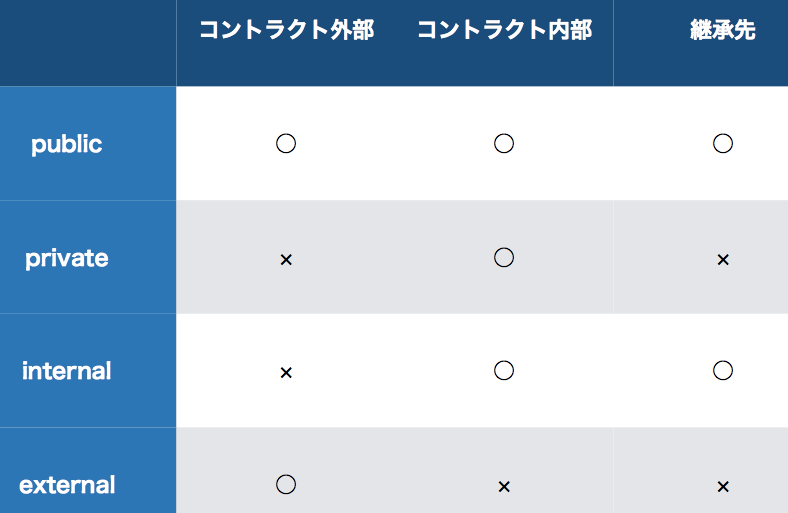

【Solidity】private、public、internal、externalの違いとは?相互情報量の特徴選択への応用

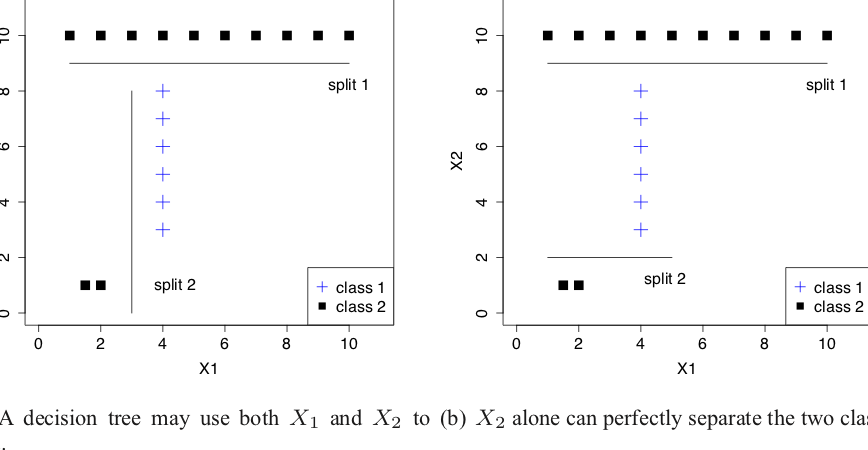

相互情報量計算は、特徴選択のための指標として使用することができます。特徴選択とは、機械学習モデルの性能を向上させるために、重要な特徴量を選択することを指します。相互情報量を使用することで、各特徴量との相関関係を観察し、重要な特徴量を選択することができます。相互情報量が高くなるほど、特徴量同士の相関関係が強いことを示します。

実際の例

ここでは、実際の例を通じて、相互情報量計算を適用します。 Iris データセットを使用して、特徴選択を行います。まず、 Iris データセットをロードし、相互情報量を計算します。

| 特徴量 | 相互情報量 |

|---|---|

| sepal length | 0.52 |

| sepal width | 0.35 |

| petal length | 0.65 |

| petal width | 0.58 |

まとめ

本稿では、相互情報量計算の基本概念から、特徴選択への応用までをexplainedしました。scikit-learnを使用することで、相互情報量計算を簡単に実装できるようになります。特徴選択における相互情報量の応用は、機械学習モデルの性能を向上させるために非常に有効です。

よくある質問

相互情報量の計算結果がNaNになる原因は何ですか?

計算結果がNaN(Not a Number)になる原因はいくつかあります。 データの前処理 が不十分である場合、 NaN値 が含まれていることが原因かもしれません。また、 べき乗の計算 で膨大な値が出る場合もNaNになる可能性があります。計算結果がNaNになる場合は、データの前処理や計算方法を再確認する必要があります。

【SQL】join、group by、sum、countを組み合わせた応用テクニック相互情報量計算に何種類のアルゴリズムがありますか?

相互情報量 計算には、 PMI(Pointwise Mutual Information) や MI(Mutual Information) 、 NMI(Normalized Mutual Information) などのアルゴリズムがあります。PMIは、2つの特徴量の相互関係を捉えるために使用され、MIは、2つの特徴量の相互情報量を計算するために使用されます。NMIは、MIの値を正規化するために使用されます。

特徴選択に相互情報量を適用する利点は何ですか?

相互情報量 を特徴選択に適用する利点はいくつかあります。 冗長な特徴量の除去 が可能となり、 モデル性能の向上 に貢献します。また、 計算コストの削減 も期待できます。相互情報量を適用することで、 最適な特徴量の選択 が可能となります。

sklearnで相互情報量計算を行うための関数は何ですか?

sklearn では、 mutual info classif 関数や mutual info regression 関数を使用して相互情報量を計算できます。mutual info classif関数は、分類問題での相互情報量計算を行うために使用され、mutual info regression関数は、回帰問題での相互情報量計算を行うために使用されます。これらの関数を使用することで、簡単に相互情報量を計算できます。

【Stable Diffusion】UbuntuサーバーでWebUIを動かす!SDXL対応も