Pythonスクレイピング:robots.txtチェックツールを作ろう

インターネット上の情報を($)するための vazgeç.scrollViewingという手法があるが、.websiteの所有者が定めるルールに反する行為を避けるため、robots.txtという規約が存在する。Scrapingを行う上で、robots.txtの規約を遵守することは非常に重要である。しかし、手動でrobots.txtをチェックするのは時間のかかる作業である。この記事では、Pythonを使用してrobots.txtチェックツールを作成し、Scrapingの効率化を目指す。

Pythonスクレイピング:robots.txtチェックツールの作成

Pythonスクレイピングにおいて、ウェブサイトのrobots.txtファイルをチェックするツールは非常に重要です。robots.txtファイルは、ウェブサイト所有者が検索エンジン等に対して、ウェブサイト内の指定されたページやディレクトリーにアクセスしないように指示するためのファイルです。このファイルをチェックすることにより、ウェブスクレイピングを行う際にはウェブサイトの所有者が許可していないページやディレクトリーにはアクセスしないことができます。

robots.txtファイルとは

robots.txtファイルは、ウェブサイトのルートディレクトリーに置かれる、プレーンテキスト形式のファイルです。このファイルには、ウェブサイト所有者が検索エンジン等に対して指示するルールが記述されています。例えば、指定されたページやディレクトリーにアクセスしないように指示する「Disallow」ルールや、指定されたページやディレクトリーにアクセスすることを許可する「Allow」ルールなどがあります。

Pythonでrobots.txtファイルをチェックする方法

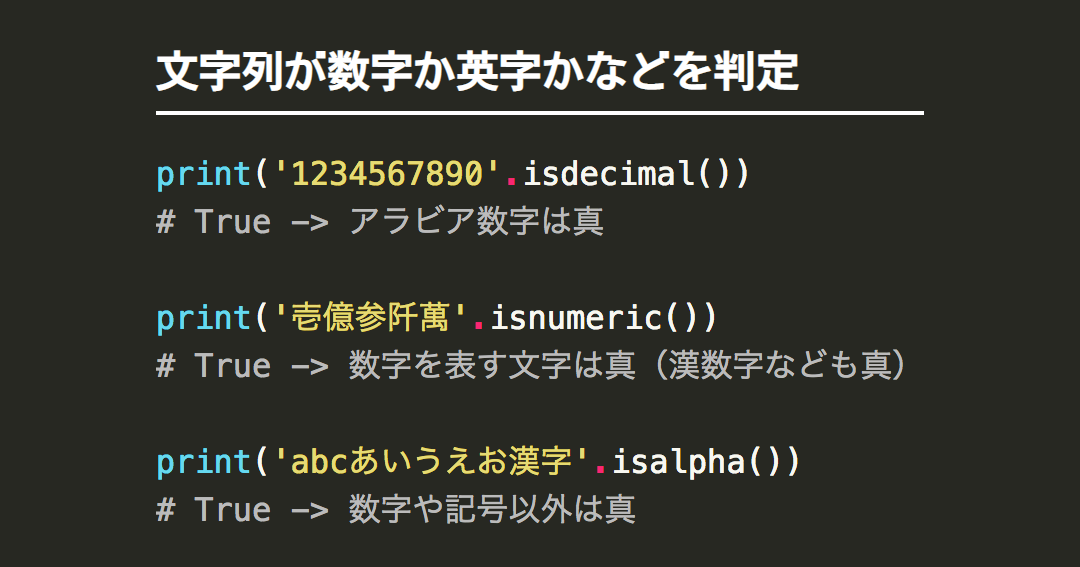

Pythonでは、robots.txtファイルをチェックするためのライブラリがいくつかあります。例えば、python-robots-txtというライブラリでは、robots.txtファイルをパースし、指定されたURLに対するアクセス許可や禁止をチェックすることができます。また、robotparserというモジュールもあり、robots.txtファイルをパースし、指定されたURLに対するアクセス許可や禁止をチェックすることができます。

Pythonヌルオブジェクト比較:Noneとの違いは?ツールの作成

ツールの作成には、Pythonのライブラリやモジュールを使用します。まず、robots.txtファイルをパースするためのライブラリをインポートし、指定されたURLに対するアクセス許可や禁止をチェックするための関数を作成します。次に、ユーザーインターフェースを作成し、URLを入力するためのフォームや、チェック結果を表示するための領域を作成します。

実際の例

ここでは、python-robots-txtというライブラリを使用して、robots.txtファイルをチェックするツールを作成します。まず、ライブラリをインポートし、robots.txtファイルをパースするための関数を作成します。

| URL | アクセス許可 |

|---|---|

| https://example.com/ | 許可 |

| https://example.com/admin/ | 禁止 |

将来の展望

将来的には、robots.txtファイルをチェックするツールに、より多くの機能を追加することができます。例えば、ウェブサイトの所有者が許可していないページやディレクトリーにアクセスすることを検出するための機能や、検出結果をメールやSlackなどで通知するための機能などがあります。

よくある質問

Q1:Pythonスクレイピングのロボット排除標準について

ロボット排除標準(robots.txt)は、ウェブサイトが提供する指令集で、スクレイピングツールがそのサイトをアクセスすることを制限するものです。この規格に従えば、スクレイピングツールが不当なアクセスを避けることができます。Pythonのスクレイピングライブラリでは、`Requests`や`Scrapy`などのフレームワークを使用して、ロボット排除標準をチェックすることができます。これにより、ウェブサイトの所有者の意向を尊重し、 スクレイピングの倫理的 な実施が可能になります。

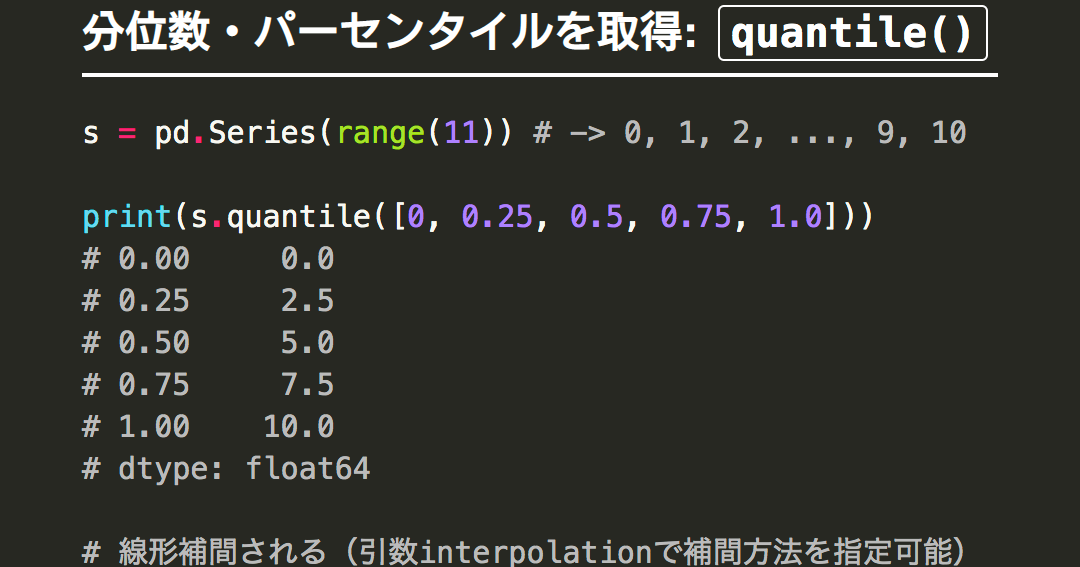

Pythonでパーセンタイル値を計算する方法Q2:robots.txtチェックツールの作成について

Pythonを使用して、ロボット排除標準をチェックするツールを作成するには、まずは`requests`ライブラリを使用して、robots.txtファイルを取得します。次に、取得したファイルをパースして、アクセス許可 や アクセス禁止 の情報を抽出します。最後に、抽出した情報に基づいて、スクレイピングツールがアクセスすべきか否かを判断するロジックを実装します。このツールを作成することで、 効率的なスクレイピング を実現することができます。

Q3:robots.txtファイルの場所について

ロボット排除標準のファイル(robots.txt)は、ウェブサイトのルートディレクトリーに置かれます。つまり、例えば「https://example.com/」というウェブサイトでは、「https://example.com/robots.txt」というURLにアクセスすることで、robots.txtファイルを取得することができます。このファイルの場所 を知っておくことで、スクレイピングツールが正しくロボット排除標準をチェックすることができます。

Q4:スクレイピングツールの倫理的実施について

スクレイピングツールを使用する際には、ウェブサイトの所有者の意向を尊重し、 倫理的 な実施を行うことが重要です。ロボット排除標準をチェックすることで、スクレイピングツールが不当なアクセスを避けることができます。また、スクレイピングツールを使用する際には、ウェブサイトのサーバーに負荷をかけないように注意する必要があります。 責任のあるスクレイピング を実施することで、ウェブサイトの所有者との信頼関係を構築することができます。

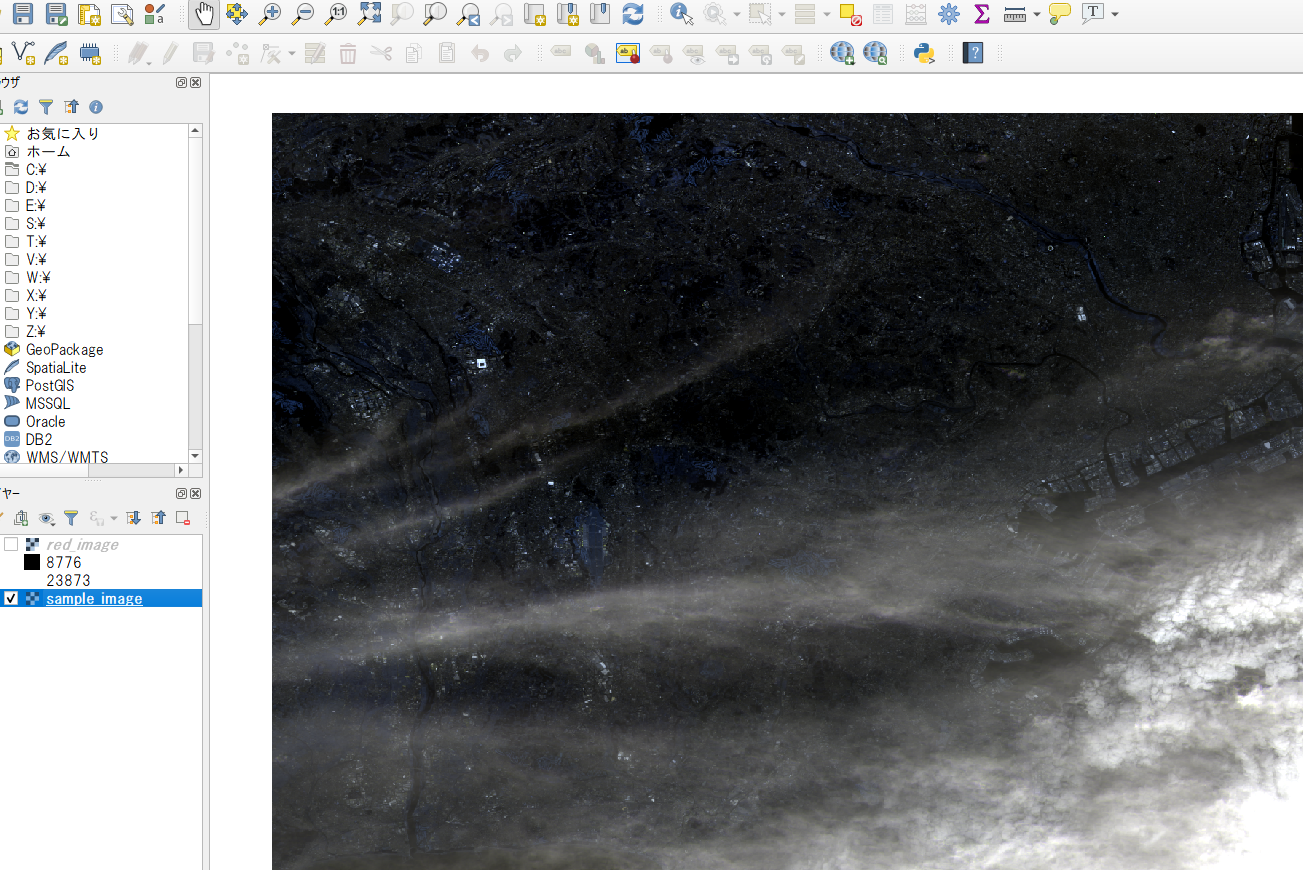

Pythonでラスタデータ解析:バンド情報抽出